服务咨询

全天高效服务

- Tel:13533491614

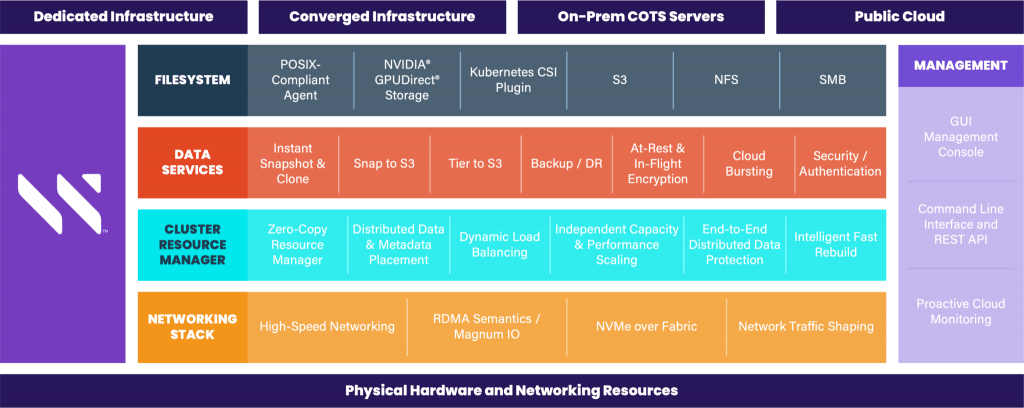

了解用于企业 AI 工作负载和高性能应用程序的现代数据

平台背后的技术。

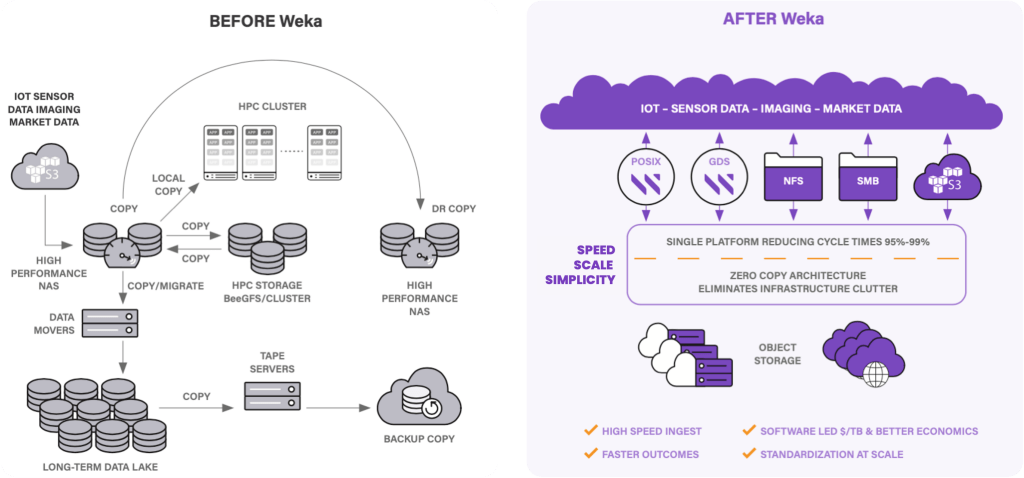

要在生产环境中成功部署 AI 项目,您的基础架构必须能够快速处理非常大的数据集,并从各种来源中摄取结构化和非结构化数据。传统的高性能处理存储架构不断地将数据从一个存储系统移动到另一个存储系统(用于归档数据的对象存储、用于持久存储的 NAS、用于快速存储的并行文件系统)随着数据传输时间的延长,增加了复杂性和管理并减慢了结果。

实施人工智能项目的关键技术挑战是如何有效地填充管道、如何轻松地跨系统集成以及如何管理快速变化。

AI 管道的每个步骤通常具有完全不同的数据 IO 配置文件,这导致管道中的复杂性、存储孤岛和数据停滞。

需要从多个来源并通过多种协议摄取数据。当今的 AI 工作负载需要在本地和云端运行。

传统基础设施可能需要数月至数年才能改变,然而,科学变化更快,基础设施需要能够在数周内适应。

在本地、云端和平台之间无缝运行

以更短的纪元时间、最快的推理和最高的图像,秒基准来加速大规模数据流水线

支持本机 NVIDIA GPUDirect 存储、POSIX、NFS、SMB 和 S3 对数据的访问

在同一个存储后端上运行整个管道,并消除副本的成本和停顿

世界上最快的文件系统,支持高 I/O、低延迟、小文件、混合工作负载和数据可移植性

在您选择的硬件上运行,并在新的服务器技术可用时立即支持它们

“WEKA IO 是我们 DNN 培训的明确选择……标准 NAS 无法扩展,而 WEKA 是我们评估的所有并行文件系统中性能最高的……我们真的很喜欢它独立于硬件,使我们能够更好地控制基础设施成本。 ”

——侯晓迪博士,联合创始人兼首席技术官